Sommaire

- 1 Des “programmes de vérité”

- 2 Les “faiseurs de monde”

- 3 Conclusion : des communautés de vérité

- 3.1 Cinq problèmes avant de conclure

- 3.1.1 Réalistes et nominalistes : l’éternel débat…

- 3.1.2 Les cadres de l’action collective

- 3.1.3 De la vérité au doute : dynamiques de l’expérience des programmes

- 3.1.4 Matérialité, membres et formes de vie de la culture numérique

- 3.1.5 Politique de l’accord, du commun et de la fragilité

- 3.2 Pour finir : qu’est-ce qu’une communauté de vérité ?

- 3.1 Cinq problèmes avant de conclure

- 4 Lexique

- 5 Bibliographie

“Loin d’être un maître solennel et sévère, la vérité est un serviteur docile et obéissant” (Nelson Goodman)

Nous avons souvent tendance à qualifier d’ ”idéologiques” des idées qui ne sont pas les nôtres1Ce billet est une réécriture et une très large extension d’un article à paraître dans Pascal Robert, L’Impensé numérique, t.2, Editions des Archives, courant 2018.. Dans un petit livre aussi bref que dense, l’historien de l’antiquité gréco-romaine Paul Veyne (1983) propose de remplacer les notions d’ ”idéologie”, de “mythe”, d’ ”imaginaire” ou même de “croyance”, qui servent généralement à sanctionner des valeurs étrangères, par celle de “programme de vérité”.

Des “programmes de vérité”

Vérité, confiance et mauvaise foi

Selon Veyne, il n’y aurait pas d’un côté des vérités et de l’autre des erreurs : il n’existerait que des “programmes de vérité”*2Chaque terme avec une astérisque est défini dans le lexique. que se fixent à un moment donné des “personnes”3La notion de personnes vient ici remplacer celle d’ ”acteurs”, d’ ”agents” ou d’ ”usagers” : elle présuppose une capacité d’action chez chacun d’entre nous qui n’est pas nécessairement déterminée par une situation dans laquelle s’engagent les personnes. Corrélée à celle de capacité — voir note d’après -, la notion de personne réintroduit de l’incertitude, de l’imprévu dans l’étude de l’action humaine. Voir Luc Boltanski et Laurent Thévenot, De la justification, Gallimard, 1991. et auxquels elles adhèrent par conviction, mauvaise foi ou opportunisme, parce qu’elles ont un temps confiance en l’expertise de leur promoteur.

Car elles ne sont jamais tout à fait dupes : elles peuvent croire et ne pas croire, adhérer à ce qui se présente à une vérité en un lieu (dans un espace public) et y renoncer à un autre (chez soi), choisir de suspendre leur crédulité un moment (le Père Noël existe) et se montrer incrédule ensuite. Nous savons bien mais quand même (Lambert, 2014)... Bref, les personnes sont compétentes ou capables4La capacité est un principe de la sociologie pragmatique qui prête aux personnes des aptitudes à analyser leur propre situation : elles n’appliquent pas bêtement un script ou un programme mais l’actualise en fonction de leurs intérêts, de leurs croyances, de l’intensité de leur adhésion. Voir Cyril Lemieux, La Sociologie pragmatique, La Découverte, 2018: si nous adhérons parfois sans résistance à des programmes (publicitaires, politiques, etc.), rien ne permet de dire que nous faisons toujours corps avec eux, avec la même intensité et sans distanciation. Bien au contraire, nous sommes capables de réviser nos jugements, voire de changer d’opinion, en fonction de notre environnement et de ses fluctuations. Les “programmes de vérité” relèvent ainsi d’une analyse pragmatique et dynamique des jugements, des valeurs et des actions humaines.

Les Grecs croient et ne croient pas à leurs mythes : ils y croient mais ils s’en servent et ils cessent d’y croire là où ils n’y ont plus d’intérêt. (…) tous les peuples donnent un coup de pouce à leurs oracles ou à leurs indices statistiques pour se faire confirmer ce qu’ils désirent croire.” (Paul Veyne, Les Grecs ont-ils cru en leurs mythes, Seuil, 1983, p. 94)

Le recours à ce concept a un intérêt discret mais majeur : d’une part, il permet de ne pas présumer a priori des tentatives de manipulation ou de falsification d’un réel donné chez les promoteurs d’un programme (une “start-up” peut sincèrement croire qu’elle va changer le monde, en dépit de ses logiques marchandes et stratégiques) ; d’autre part, il pointe la part de participation des personnes à qui s’adressent ses programmes, en montrant comment elles y adhèrent et selon quelles modalités. En parlant de “programmes de vérité” (ou de “weltanschauung”5Les philosophes allemands, comme Kant ou Dilthey, ont particulièrement travaillé la question des “conceptions du monde” à partir de la notion de “weltanschauung”. Très complexe, elle semble impliquer la manière dont des hommes agencent leur mode de vie. Voir Christian Berner, Qu’est-ce qu’une conception du monde ?, Vrin, 2006. On verra cependant que les programmes de vérité diffèrent en partie de cette notion : ils admettent une partie résistante de réel, là où la théorie des conceptions du monde semble, dans certains cas, excessivement mentaliste.), nous évitons de réfléchir uniquement en termes de manipulation ou d’influence pour comprendre comment et pourquoi les programmes s’ajustent aux personnes ou à des collectifs de personnes, sans nier pour autant la part de coercition ou les rapports de force qui peuvent s’instaurer dans ces programmes et entre des programmes.

Un exemple : le programme de vérité du web (dit) 2.0

Un exemple (que je travaille de manière plus approfondie ensuite) : le programme du web (dit) 2.0. Le 10 décembre 2006, Tim O’Reilly, entrepreneur et promoteur de cette expression, finit par proposer la définition suivante :

Web 2.0 is the business revolution in the computer industry caused by the move to the internet as platform, and an attempt to understand the rules for success on that new platform. Chief among those rules is this: Build applications that harness network effects to get better the more people use them. (This is what I’ve elsewhere called “harnessing collective intelligence.”)

Or, un an sépare cette définition ultime d’un premier texte daté du 30 septembre 2005 (“What is Web 2.0 ?”) où O’Reilly cherchait à catégoriser une série de transformations observées sur Internet. De septembre 2005 à décembre 2006, son texte a bénéficié des suggestions de personnes qui, dans leurs commentaires, ont amendé, corrigé ou validé des éléments de sa première définition. Dans le texte de 2006, O’Reilly lui-même rappelle sa dette en matérialisant explicitement les débats suscités par sa définition, qui n’en était manifestement pas encore une :

Progressivement, ce texte est devenu un point de ralliement entre des pratiques, des personnes, des mondes hétérogènes (Rébillard, 2011) qui s’en réclament parfois de manière opportuniste ou parce qu’il a simplement été naturalisé, “impensé” comme dirait Pascal Robert (2016), c’est-à-dire soustrait au débat public au point d’être aujourd’hui convoqué médiatiquement avec la force d’un réflexe pavlovien (“génération 2.0”, “émission 2.0”, etc.). Mais cette soustraction s’est faite après d’importants débats où O’Reilly s’est ajusté aux personnes. Autrement dit : les uns et les autres se sont mutuellement reconnus et élus dans la définition conjointe de leur programme de vérité qui atteste d’une polyphonie énonciative.

Dans cette perspective, on définira l’ajustement* comme l’opération par laquelle “les sujets élaborent dans la durée les normes, croyances, confiances et postures.” (Jeanneret, 2014, p. 87)

Programmes et “Maître de vérité”

Un tel processus ressemble à bien à des égards au portrait que Marcel Detienne fait des Maîtres de vérité dans la Grèce archaïque (2006) : à cette époque, la parole du roi, du devin et du prêtre n’est jamais questionnée : elle est de type assertorique ; elle est “un discours de vérité” qui énonce “ce qui a été, ce qui est, ce qui sera.”

S’ils ne recherchent pas l’assentiment de leur communauté, le roi, le devin et le prêtre sont cependant soumis respectivement à trois ordres transcendants : le Droit, la Mantique, la Muse. Pour que leur parole reste socialement insoumise, ils doivent paradoxalement respecter les ordres reconnus par leur groupe social.

la vérité se définit à deux niveaux : conformité à des principes logiques d’une part, conformité au réel d’autre part, et par là elle est inséparable des idées de démonstration, de vérification, d’expérimentation. (Detienne, 2006, p. 51)

Maîtres et groupe sont donc indissociables : ils s’ajustent l’un à l’autre, définissent conjointement, reconnaissent les normes, les valeurs, les confiances et les postures dont ils ont mutuellement besoin pour s’organiser socialement. C’est pourquoi la tromperie ou la manipulation des Maîtres est bien relative, même si Détienne reconnaît son existence : plus que des virtuoses de la triche, de la ruse et du mensonge, ce sont les figures visibles d’un programme de vérité.

Bilan partiel : la vérité comme énoncé convenable naturalisé

À suivre ma lecture de Veyne et Détienne, on pourrait croire que je souscris au paradigme constructiviste de première génération, excessivement mentaliste et relativiste, encore parfois présent en sciences humaines et sociales. En fait, leur propre positionnement est plus nuancé. Chez Veyne comme chez Détienne, les programmes s’ajustent, même s’ils finissent par s’imposer de manière transcendante : qu’ils soient négociés par les personnes ou qu’ils soient en adéquation avec des cadres institutionnels (le roi respecte la justice), ils sont toujours auto-contraints, soumis à des “contraintes d’acceptabilité” (Ogien et Quéré, 2005a), sont entrelacés dans un tissu social, historique, institutionnel, normatif, langagier.

Les programmes de vérité ne sont pas des conventions qui émergeraient ex nihilo des sables sociaux ; ils ne sont pas non plus relatifs : ils se construisent à partir d’objets plus moins stabilisés, plus ou moins déjà présents, quoique toujours rejoués, réactualisés, transformés : les productions humaines ne procèdent pas de rien6Je reprends à mon compte la thèse de Ricoeur défendu dans un dialogue avec Castoriadis. Voir Cornelius Castoriadis et Paul Ricoeur, Dialogue sur l’histoire et l’imaginaire social, Éditions de l’EHESS, 2016.. Bref, ils sont réels, ils ne dépendent pas de l’avis de telle ou telle personne qui pourrait proférer sa propre vérité. Cette dernière, pour être acceptée, est en adéquation avec ce qu’un groupe social est plus ou moins disposé à accepter.

Mais elle fait aussi l’objet de stratégies de configurations des publics, de cadrages expérientiels et de luttes de reconnaissance : le processus qui mène à un programme de vérité, à la soustraction d’une idée de tout débat public, est long, semé d’embuches. Avant d’être impensé, un programme de vérité est surpensé : il est débattu, négocié, progressivement ajusté, à mesure que les publics sont eux-mêmes configurés ; il subit un processus progressif de naturalisation. À la suite des philosophes du langage ordinaire (Wittgenstein, Cavell), je considère ainsi qu’une convention “n’est pas ce qui est arbitraire ou objet d’un choix mais bien plutôt ce qui est devenu nécessaire” (Laugier, 2018, p. 208). Nous ne sommes pas les auteurs de nos accords et de nos conventions : nous ne faisons que retrouver en eux les forces qui contribuent à leur genèse et qui, en retour, s’en trouvent modestement infléchies.

Mettre au jour ces forces et leurs infléchissements implique une entreprise archéologique (Foucault, 1969) : nous chercherons ainsi à comprendre ce qui a rendu possible un certain type d’énoncés (“Candide 2.0”, par exemple), à partir de quelles formations discursives elles s’établissent et comment ces dernières se sont progressivement constituées par le truchement des médiations, des transformations, des stabilisations progressives et des querelles sourdes entre les programmes de vérité. Les programmes de vérité relèvent en partie, moyennant quelques ajustements et articulations avec d’autres concepts, des “régimes de vérité” qui invitent à se demander quels :

types de discours [une société] accueille et fait fonctionner comme vrais ; les mécanismes et les instances qui permettent de distinguer les énoncés vrais et faux, la manière dont on sanctionne les uns et les autres ; les techniques et les procédures qui sont valorisées pour l’obtention de la vérité ; le statut de ceux qui ont la charge de dire ce qui fonctionne comme vrai. (Foucault, 1976)

Ce projet est très proche de la conception Nietzchienne de la vérité :

Qu’est-ce donc que la vérité ? Une multitude mouvante de métaphores, de métonymies, d’anthropomorphismes bref, une somme de relations humaines qui ont été rehaussées, transposées , et ornées par la poésie et par la rhétorique, et qui après un long usage paraissent établies, canoniques et contraignantes aux yeux d’un peuple : les vérités sont des illusions dont on a oublié qu’elles le sont, des métaphores usées qui ont perdu leur force sensible, des pièces de monnaie qui ont perdu leur effigie et qu’on ne considère plus désormais comme telles, mais seulement comme du métal. (Nietzsche, Vérité et mensonge au sens extra-moral, 1873)

Nietzsche déplace le problème de la recherche de la vérité, qui fait l’objet d’une vénération en philosophie, vers l’interprétation : pour lui, une vérité n’est rien d’autre qu’une interprétation possible qui a réussi socialement à se faire oublier comme telle. Pour autant — j’insisterai souvent sur ce point — tout ne se vaut pas ; la philosophie de Nietzsche n’est pas relativiste : toutes les interprétations ne sont pas équivalentes ; elles exigent de la rigueur. S’il existe une pluralité de points de vue, cette pluralité “suppose un cadre dialogique qui suppose de donner des raisons d’adhérer à telle thèse et des arguments pour répondre aux objectifs qu’on lui oppose.” (Morizot, 2015, p. 545)

Pour résumer, nous ne cherchons plus à comprendre si un énoncé est juste ou pas (perspective idéologique ou cohérentiste de la connaissance), avant d’en sanctionner la teneur, mais comment il est devenu socialement possible, c’est-à-dire pourquoi il est convenable (Austin, 1962 ; voir Laugier, 2008) : le travail d’ajustement est l’indice d’une recherche rigoureuse (Brague et al., 2004) de convenabilité entre les personnes qui n’enlève rien aux luttes violentes et querelles sourdes de cette recherche.

C’est ici un léger point de divergence avec les Mythologies de Barthes (1957), livre de sémiologie critique pour lequel j’ai cependant une grande admiration : son auteur cherche à montrer comment la bourgeoisie naturalise sa propre culture par le truchement de signes qui envahissent l’espace public à tel point que ses valeurs, éminemment situées et relatives, finissent par innerver toute une société avec la force de l’évidence et sans possibilité de contestation. Or Barthes fait l’impasse sur le processus d’ajustement entre les personnes. Son projet est en effet différent : dans une perspective marxiste, il s’agit plutôt de montrer comment une culture (bourgeoise) s’impose sourdement à toutes les autres. Je n’ignore évidemment pas ces rapports de force, qui peuvent être violents et transcendants (Marcel Détienne fait d’ailleurs remarquer que les Maîtres de vérité sont aussi des manipulateurs) mais il me semble que la réussite d’un programme de vérité relève d’une stratification ou d’un tressage un peu plus complexe.

Explorons maintenant cette question, à la jonction du programme mythologique, de l’archéologie des savoirs, de la socio-philosophie américaine et de l’approche communicationnelle.

Les “faiseurs de monde”

Les “communautés de discours”

Comment une convention naturalisée (ou un programme de vérité) devient-elle nécessaire et convenable, c’est-à-dire évidente, impensée, naturelle ? Jusque-là, nous avons vu que les programmes de vérité résultaient d’un processus conjoint d’ajustement entre des Maîtres de vérité et des personnes ou collectifs de personnes, qui se rencontrent dans le langage et dans des dispositifs transcendants (normes, institutions, règles, etc.). Autrement dit : l’ajustement est contraint par des cadres qui préexistent à l’accord des uns et des autres ; c’est pourquoi le rôle des Maîtres et des collectifs, s’il est réel, n’est pas suffisant pour expliquer la formation des programmes de vérité. Avant d’explorer cette question, je chercherai à qualifier ces “collectifs de personnes” et à examiner leur rôle dans la constitution des Maîtres et des programmes. Nous aurons ensuite à élargir la formation des programmes à d’autres critères et d’autres processus.

Pour travailler la question des “collectifs de personnes”, nous avons besoin d’un concept qui permette à la fois de penser l’ajustement des personnes, les contraintes qui pèsent sur elles et les cadres dans lesquels elles s’épanouissent. La notion de “communauté de discours” (Krippendorff, 2011) me semble utile et compatible avec ma problématique et les travaux précédemment cités : elle désigne un “dialogue systématiquement contraint” qui s’auto-organise. Cinq modalités régissent l’émergence et la maintenance des discours (ou, si l’on préfère, des programmes de vérité) :

- La matière textuelle, soit l’ensemble des traces (œuvres, littératures, images, enregistrements, artefacts technologiques, etc.) produites par une communauté de discours dont les membres partagent des compétences d’écriture et de lecture ;

- Le dynamisme des personnes, capables de s’approprier les discours, de les retravailler et de faire circuler leur matière d’une communauté à une autre, pour réélaborer leur sens en s’appuyant sur des critères co-définis et valables au sein d’un espace donné ;

- L’institutionnalisation : les personnes d’une communauté de discours mettent progressivement en place des normes, des traditions, des pratiques qui se maintiennent grâce aux contraintes que chacun d’entre eux fait peser sur l’autre, au point qu’elles deviennent naturelles, alors même qu’elles se sont auto-construites ;

- Les frontières : toute communauté discursive définit des règles d’appartenance qui permettent d’inclure ou de discréditer un membre. Certes, une communauté a besoin de membres d’autres communautés pour croître, en s’appuyant sur leurs ressources intellectuelles et matérielles. Mais cette ouverture relative n’est possible qu’à condition que soient reconnues les compétences de chacune d’entre elles ;

- La justification : c’est parce qu’un discours est justifié qu’il reçoit un crédit extérieur. Il exhibe ses qualités ou celles de ses artefacts et des compétences de ses membres.

Cette proposition est d’abord utile pour penser les productions des “collectifs de personnes” ou des “communautés de discours” : ils conçoivent des artefacts (textes, images, logiciels, etc.) pour incarner leur programme. Elle permet également de montrer comment s’organise la naturalisation discursive : les discours sont d’abord débattus, ils s’organisent, avant d’être présentés comme évidents ou “affordants” dans la terminologie de Krippendorff inspiré par Gibson. Ils sont également dynamiques, c’est-à-dire opportuns : ils s’ajustent et s’adaptent sans arrêt. Enfin, même ils s’auto-organisent, ils s’inscrivent dans des cadres, des institutions, des règles et des normes qui les informent sans les contraindre tout à fait.

On pourrait même aller plus loin et considérer, avec Wittgenstein et les ethnométhodologues (Garfinkel, 1967), que les personnes ne font que retrouver, dans leurs interactions, non seulement les accords qui pré-existent à leurs négociations mais, bien plus, le seuil même des instruments (langage, institutions, etc.) à partir duquel ils se mettent d’accord7“La démarche ethnométhodologique reconnaît et prend toute la mesure d’un fait : la généralité de l’ordre dans le monde social ; et en déduit un principe d’analyse : rien de la vie que nous menons n’échappe jamais ni le moindre instant à une forme d’organisation sociale d’une activité pratique. C’est donc ce fait et ce principe qui fondent la pertinence du constat sur lequel ses analyses se développent : les individus agissent en mobilisant, dans la réflexivité de l’action, ce “savoir de sens commun des structures sociales“ qui ne cesse de les habiter.” Voir Ogien et Quéré, 2005c. Si nous ne pouvons pas dire n’importe quoi, si les Maîtres sont toujours audibles, c’est parce qu’ils ne parlent qu’à l’intérieur du langage humain dans lequel ils tentent d’être compris. Comme l’écrit le philosophe analytique Nelson Goodman (1992[1978]) :

Quoiqu’on ait à décrire, on est limité par les manières de décrire.

Ma position est ainsi proche de l’émergentisme raisonné (voir Chauviré et Ogien, 2001), ou d’un nominalisme rigoureux (Goodman) : les phénomènes sociaux peuvent émerger, s’organiser d’eux-mêmes mais à l’intérieur de cadres qui les autorisent, les rendent lisibles et signifiants socialement, non parce qu’ils existeraient indépendamment d’eux (position du réalisme sémantique ; Tiercelin, 2013), mais parce que ces mêmes cadres, rejoués au cours des interactions des personnes, sont eux-mêmes construits à partir d’anciens cadres ou d’anciennes configurations, à leur tour actualisés et reconfigurés. Nous aurons largement l’occasion de travailler cette question.

Questions et exemples au travail

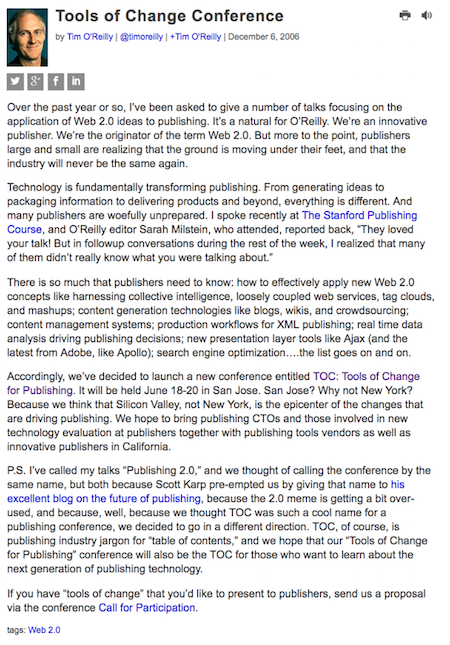

Pour mettre à l’épreuve ces concepts, je travaillerai tout au long de ce billet sur le web (dit) 2.0 à partir de multiples terrains. Il est particulièrement utile pour conceptualiser et théoriser la notion de “programme de vérité”, de “communauté de discours” et de “Maître de vérité” dans la mesure où, nous l’avons vu, il s’est auto-ajusté, bénéficie encore aujourd’hui d’une figure tutélaire (Tim O’Reilly) et a circulé dans d’autres mondes sociaux (comme le projet Candide 2.0 développé par la New York Public Library). En effet, O’reilly ne s’est pas contenté de “faire monter en généralité”, comme disent les sociologues (Quéré, 1994), un ensemble de discours concordants en proposant de les rassembler (ou de les typifier) sous l’épithète “2.0”. Il a, bien plus, contribué à sa circulation sociale en lançant notamment Tools of Change for Publishing (2007–2013), une conférence internationale sur l’édition numérique, chargée d’accompagner la transformation du monde du livre.

Retenons maintenant quelques questions pour mettre à l’épreuve les concepts précédemment cités et le cadre général. Je le rappelle : il ne s’agit plus de mettre au jour des stratégies de falsification du réel, comme s’il existait d’un côté des gourous et de l’autre des captifs ; il s’agit plutôt d’identifier un tressage fin de personnes, de Maîtres, de matières textuelles, de valeurs, de normes, d’actions à partir desquels émergent des programmes de vérité. D’où les questions suivantes, retravaillées et problématisées pour aborder mon propre corpus (Tim O’Reilly lui-même, la conférence Tools of Change et le projet Candide 2.0) :

- Quels sont les programmes de vérité de Tim O’Reilly et de sa conférence internationale, Tools of Change for Publishing (2007–2013) ? De quelles matières textuelles (images, commentaires, textes, logiciels, etc.) sont-ils constitués ? Comment a‑t-il été naturalisé et pourquoi est-il convenable ?

- Comment a été mis en signe Tim O’Reilly, son expertise et la confiance qu’il inspire ? Qu’est-ce qui a socialement et historiquement permis l’émergence de ce Maître ? De quels discours est-il lui-même héritier ?

- Comment s’est pérennisé et a circulé le programme de vérité de la communauté de discours de Tim O’Reilly ? Qu’est-ce que le projet Candide 2.0 reprend du programme de vérité de Tools of Change for Publishing ? Qui l’a fait circuler dans un nouvel espace social ? Selon quelles modalités ? Quelles compétences font valoir la nouvelle communauté de discours de ce programme de vérité ? Comment qualifier l’institutionnalisation de ce programme de vérité ?

N’ayant affaire qu’à des traces et n’ayant pas mené d’entretiens avec les personnes concernées, je travaillerai principalement à partir de signes, d’indices et de marqueurs : mon but est de repérer, dans une matrice textuelle et éditoriale donnée et reliée pertinemment, un ensemble d’éléments qui permettent de mettre d’abord au jour des “communautés de discours” et des “Maîtres de vérité”, dans une démarche dynamique. Ce parti pris relève de la théorie de l’énonciation éditoriale (Souchier, 2007), c’est-à-dire d’une tentative pour identifier, repérer et faire parler un ensemble d’éléments textuels dont on présuppose le potentiel indiciel, métonymique et symptomatique.

Tim O’Reilly : un Maître de vérité

Que ce soit sur O’Reilly (site mère de l’entreprise d’Oreilly), sur O’Reilly Radar (site de veille sur les nouvelles technologies), ou sur le site de l’événement Tools of Change for Publishing, Tim O’Reilly est toujours présenté en termes mélioratifs et parfois même comme un “oracle” (sic). Il est l’indice d’un travail pour l’instituer comme Maître de vérité.

Une figure mantique

Il assure d’ailleurs très bien le rôle qui lui a été ou qu’il s’est assigné : sur sa page personnelle, son expertabilité s’impose d’emblée. Elle s’apparente à une anthologie personnelle qui démontre visuellement son autorité et organise une matière disparate (entretiens, articles, vidéos, etc.) autour d’un seul énonciateur. Ces matières textuelles sont également structurées à partir d’un rubricage (“Tim’s Best”, “Some pieces on Web 2.0 and the enterprise”, “The Publishing Point Interviews”) qui donne à lire son parcours de manière “affordante”, pour reprendre Krippendorff. Dans cette perspective, il apparaît comme une figure quasi mantique qui avait tout anticipé.

On trouve en effet trace de ce statut dans les biographies dispersées sur l’ensemble des sites précédemment mentionnés. La formule suivante revient sans arrêt (voir Figure ci-dessus), en parlant du blog d’Oreilly : “[it] determines emerging technologie trends, and serves as a plateform for advocacy about issues of importance to the technical community”. Nous avons affaire à des indices d’un programme de vérité : Tim O’Reilly est présenté comme un devin capable de puiser dans la masse des signes disponibles des éléments d’orientation et d’action pour une communauté donnée. Comme sa biographie est identique sur tous les sites cités, nous pouvons à titre d’hypothèse considérer que nous sommes en présence d’une même communauté qui défend le même programme.

Le programme du Maître de vérité et de sa communauté

Ce programme est clairement exprimé dans le texte inaugural d’O’Reilly du 30 septembre 2005 (“What is web 2.0″ ?) qui a été retouché plusieurs fois avant de proposer la définition consensuelle suivante le 10 décembre 2006 :

Web 2.0 is the business revolution in the computer industry caused by the move to the internet as platform, and an attempt to understand the rules for success on that new platform. Chief among those rules is this: Build applications that harness network effects to get better the more people use them. (This is what I’ve elsewhere called “harnessing collective intelligence.”)

À cette époque, O’Reilly, comme beaucoup d’autres, cherchait à comprendre pourquoi certaines sociétés (Google) avaient émergé, étaient en pleine croissance, alors que d’autres (Netscape) s’étaient effondrées. Dans son article, il expliquait que les premiers avaient su développer des “services” autour de leur “produit” tandis que les seconds s’étaient excessivement focalisés sur ce dernier. Plus précisément, Google aurait su gérer l’ ”intelligence collective” en développant un algorithme capable d’indexer des productions éditoriales (les pages web) pour les mettre différemment en avant.

Dès 2005, il pose tout l’arrière-plan ou la texture doxique, technologique, axiologique, social bref, le programme de vérité du “web 2.0” : celui-ci devra s’appuyer sur la “sagesse des foules” pour faire des personnes des “co-développeurs” dont les comportements seraient suscités et analysés en temps réel grâce à des langages dynamiques (PHP, Perl, Python, Ruby) et des architectures comme AJAX.

Ce programme se trouvait alors résumé dans une métaphore. Pour O’Reilly, l’ensemble des liens hypertextes du web seraient comparables aux synapses d’un “cerveau global” (l’intelligence collective) qui entretiendrait un “dialogue mental” (“mental chatter”) entre toutes ses parties. Je reviendrai sur cette métaphore, qui permet d’identifier des racines cybernétiques et cognitivistes dans le programme d’O’reilly, soit un programme archaïque de vérité*8Les mots en astérisque font l’objet d’une définition synthétique dans le lexique, plus bas. Ils sont parfois rassemblés dans une macro-catégorie : dans “programme de vérité” pour “programme archaïque de vérité”, par exemple.

Pour résumer, les “règles du succès” reposeraient sur l’intelligence collective, les données récoltées, l’étude des publics et un ensemble de technologies émergentes. C’est en grande partie le programme anoncé de Tools of Change for Publishing le 6 décembre 2006, qui est une déclinaison du programme du Web 2.0 dans l’édition numérique :

O’Reilly se présente comme le représentant naturellement désigné (“I’ve been asked”) d’un programme qui s’appuie déjà sur celui du 10 décembre 2016 (“Web 2.0” Compact Definition : Trying Again”). S’il s’y réfère dans un autre programme (Tools of Change), c’est donc qu’il était suffisamment stabilisé. C’est la raison pour laquelle il peut multiplier des marqueurs de consensualité et de convenabilité, comme les énoncés gnomiques (“Technology is fundamentally transforming publishing”) et doxiques (“publishers larges and small are realizing that the ground is moving under their feet”) : ils traduisent un travail de naturalisation passée dont le programme de Tools of Change est l’indice.

Présence et corps du Maître

Comment le Maître, institué par une communauté de discours (“I’ve been asked” dit-il), apparaît-il matériellement sur l’ensemble de ses sites ? Biographies et photographies d’O’Reilly ont une fonction sémiotique et pragmatique, comme l’a montré Louis Marin (1981) à propos du portrait de Louis XIV : elles présentifient un Maître dont le corps est absent ; elles créent du territoire ; ce sont des matières textuelles territorialisantes*. Mais cette présentification est re-présentation : elle est présence vivante, réelle, assurée par plusieurs éléments qui dynamisent les signes visuels d’O’Reilly, les rendent vivants, comme s’il était effectivement présent. Ainsi des commentaires en bas de chacun de ses billets, qui créent la fiction d’une conversation, l’énonciation verbale (O’Reilly parle toujours directement en son nom) ou le tableau très réaliste du monde de l’entreprise et de notre société, qui s’apparente à une hypotypose, à une description en temps réel, vigoureuse.

Deuxième caractéristique de la présence du Maître ou du roi : la transformation de sa force en puissance (Marin, 1981). Tim O’Reilly est un Maître de vérité tutélaire : dans un premier temps, son portrait a surtout servi à asseoir l’autorité de la conférence, des intervenants et du public, comme en témoigne un bandeau (ci-dessous) tiré du site de l’édition 2007 dans lequel il apparaît à leurs côtés. Le Maître est ici un espace virtuel : il tire son autorité de son retrait, c’est-à-dire de la force qu’il pourrait déployer et de sa capacité à la faire exercer par ses représentants ou relayeurs de vérité*.

Le devenir décitationnel du Maître de vérité

Consécration de cette présence : sa dissolution. En 2008, le programme de vérité d’O’Reilly se transforme énonciativement. Dans le texte inaugural de Tools of Change, on trouvait la formule suivante en tête du deuxième paragraphe : “Technology is fundamentally transforming publishing.” Or, les à propos des Tools of Change suivants reprennent exactement la formule sans citer son auteur :

L’énoncé est “décitationné” pour reprendre une formule du philosophe analytique Quine (1970, 1993) : les guillemets ont été effacés de manière à le décoréler de son auteur. Cette omission est loin d’être anodine pour notre propos : en effet, aux “guillemets, on attribue l’endoxal, ce dont le sujet se désiste” (Compagnon, 1979, p. 41), ce qu’il choisit de mettre à distance. En décitationnant l’énoncé d’O’Reilly, ce petit texte témoigne à l’inverse d’une adhésion : il traduit l’assimilation du programme d’O’Reilly qui prend maintenant la forme d’un énoncé gnomique (ou “énoncé éternel” selon Quine), ces petites sentences formulées au présent de vérité générale qui circulent sans auteur, sans origine, sans emprunt ; elles instituent le réel (Certeau, 1990). Le programme n’est manifestement plus porté par un Maître de vérité mais par une communauté de discours qui le reconnaît et s’y reconnaît.

La citation est l’arme absolue du faire croire. (Certeau, 1990, p. 274)

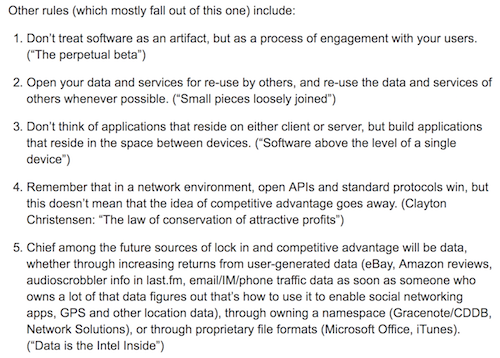

Bilan partiel : règles et apprentissage des programmes

La dispersion anonymisée du programme d’O’Reilly est non seulement l’indice d’une assimilation de son programme mais, bien plus, de la porosité des frontières entre les communautés de discours : du web 2.0 à Tools of Change for publishing, nous avons manifestement affaire à la même communauté qui semble plus ou moins défendre le même programme, adapté à l’édition.

Il reste à le vérifier. Dans son programme, O’Reilly énonce en effet un certain nombre de “règles” sur le mode impératif :

Pour autant, il n’est pas sûr que ces règles aient été intégrées ou comprises. En effet, toute règle implique un apprentissage, pour ne pas dire un “dressage” dans la terminologie de Wittgenstein (1954) : maîtriser une règle, c’est savoir l’appliquer à partir d’un apprentissage. Ainsi la directionnalité de la flèche n’est en rien évident ou absolu : nous avons appris à regarder la direction vers laquelle pointe la flèche. Cet apprentissage est complexe et conduit, plus largement, à saisir la texture ou l’épaisseur de la règle : elle témoigne d’une maîtrise sociale, normative, anthropologique.

Lorsque nous suivons une règle (suivre une flèche, suivre le programme de Tim O’Reilly), nous témoignons d’une maîtrise d’activités sociales beaucoup plus importantes que ce que la règle décrit (par exemple, traverser la rue une fois que le bonhomme est vert, c’est implicitement comprendre un ordre et une conception du monde : les modes de circulation alternée dans la ville). Un signe et une règle sont toujours des contextes d’action dont nous démontrons la maîtrise convenable au cours de leur application, qui a fait l’objet d’apprentissages répétés.

Ainsi, nous pouvons faire l’hypothèse que l’acquisition d’un programme de vérité s’accompagne nécessairement d’un apprentissage et probablement d’ ”exercices pratiques”. Vérifions-le maintenant avec le programme de Tools of Change for Publishing (2007–2014).

Tools of Change : programme d’une communauté

Quel est le programme de vérité de Tools of Change for Publishing, l’événement de Tim O’Reilly qui décline le programme du “Web 2.0” dans l’édition numérique ? S’accompagne-t-il d’ ”exercices pratiques” ? Je le répète : je n’ai pas fait d’éthnographie de cet événement ; je ne peux me fonder que sur les textes de présentation, les “matières textuelles” — pour reprendre Krippendorff — d’une communauté de discours.

Mon but est seulement de repérer la formation et la circulation d’énoncés qui se sont matériellement incarnés et pérennisés dans des artefacts (Candide 2.0). Je m’intéresse plus aux moyens qui ont été déployés pour faire du “Web 2.0” une formation discursive, un énoncé convenable et admis, en sachant qu’il reste à faire l’ethnographie sociale de son implantation et de ses résistances éventuelles.

Un programme opportuniste et convenable

On peut néanmoins tenter de dégager quelques leçons en se fondant sur les petits textes de présentation qui précédaient chaque conférence (Tools of Change était une foire internationale). Je propose un balayage rapide des thèmes (du programme de vérité) de l’événement, en revenant plus précisément sur quelques points :

- En 2007, la présence de Tim O’Reilly, qui est intervenu quatre fois (“Publishing in a Web 2.0 World”, par exemple), explique sans doute une stricte application de son programme. On trouve ainsi des conférences sur la question des données, sur le “logiciel social”, les besoins des personnes ou les nouvelles stratégies éditoriales.

- En 2008, les intervenants déploient encore les notions d’“intelligence collective”, de “longue traîne”, de gestion des “données” et de “personnalisation” : ce sont des relais discursifs d’O’Reilly, chargés de fédérer le monde éditorial à ce programme.

- En 2009, les adresses directes aux éditeurs disparaissent au profit d’un pronom collectif (“we”), qui témoigne sans doute d’un processus communautaire stabilisé. Le programme initial d’O’Reilly n’est plus explicité mais mis en application : aux éditeurs sont proposés des outils techniques pour les aider à faire leur transition.

- En 2010, de nouveaux thèmes apparaissent : dans le programme annoncé d’une conférence du co-fondateur de l’entreprise O’Reilly, le lecteur est ainsi assimilé au nœud d’un réseau dont les traces peuvent faire l’objet d’analyses statistiques.

- En 2011, l’analyse statistique et l’ “interactivité” deviennent des thèmes consensuels, impensés, justifiés sans questionnement (par exemple : “customers expect to interact”) ; les auteurs sont appelés à se saisir de la notion d’O’Reilly (“From Gutenberg to Zuckerberg”) ; la matérialité de la page imprimée est questionnée à partir du programme du Maître (passer du PDF à XML, passer de la fixité au mouvant).

- En 2012, ce programme se radicalise par endroits : la page devient la figure métonymique de la culture imprimée, qu’il s’agit désormais de dépasser (“The Death of the Page, the Dawn of Digital”) ; de manière générale, les intervenants appellent à adapter les technologies de navigation de cette culture à la culture numérique.

- En 2013, la formule “2.0” disparaît au profit de “social”. Cette transformation s’accompagne d’une multiplication des conférences destinées aux auteurs (comment augmenter ses ventes, structurer un lectorat) et de plaidoyers pour une reconnaissance de la nouvelle matérialité du livre (“Books as API”, entre autres).

De cette lecture des textes de présentation des Tools of Change on peut tirer quelques enseignements : d’abord, le programme d’O’Reilly est en grande partie respecté (XML, API, intelligence collective) ; ensuite, il bénéficie d’effets d’opportunisme : il s’adapte à ce qui est reconnu, à un moment donné, comme efficace (la notion de “social web” s’impose autour de 2010). Il bénéficie d’effets d’ajustements qui le rendent lisible socialement, pour ne pas dire évident, consensuel, convenable.

Un “jeu de langage”

La convenabilité de ce programme s’accompagne, comme j’en faisais l’hypothèse plus haut, d’exercices pratiques. Je rappelle que pour faire la démonstration de la maîtrise d’une règle (dans le cas d’O’Reilly : faire des logiciels des services, ouvrir les APIs, etc.), nous devons montrer que nous savons l’appliquer. “Maîtriser une règle” et “savoir l’appliquer” signifie : mobiliser convenablement un énoncé prescriptif dans une situation sociale donnée. Par exemple, il ne suffit pas de savoir qu’une flèche indique une direction, c’est-à-dire où aller : il faut savoir et avoir appris qu’on peut aller à un endroit donné (les toilettes d’une gare, par exemple) à certains moments (de telle heure à telle heure), en respectant des convenances (s’isoler, faire comme si les autres n’y étaient pas, etc.). Un signe indique implicitement la totalité de son contexte d’application (Deniau, 2008, 2015). Appliquer la règle énoncée par un signe revient donc à faire la démonstration que nous savons maîtriser un ordre du monde.

Quels sont les “exercices pratiques” de Tools of Change ? Quel est l’ordre du monde que les personnes sont censées maîtriser ? Quel est le contexte d’application des règles énoncées dans le programme de vérité de Tim O’Reilly ? Prenons un exemple au hasard, daté de 2013 : l’atelier “Designing And Creating A Social Book App Using Open-source Technologies” (PDF de 44 pages ici). Les objectifs proposés (envisager le livre socialement, comme une micro-communauté grouillant dans ses pages ; concevoir des gestes “affordants” ; intégrer des outils Open Source pour rendre le livre interopérable) correspondent grosso modo aux règles de Tim O’Reilly (voir le” bilan partiel” plus haut), à savoir : penser à son logiciel comme un service communautaire et participatif, ouvrir ses données et utiliser des outils ouverts sans négliger pour autant la part marchande de ses activités, envisager des relations entre les différents espaces médiatiques.

Qu’est-on censé maîtriser en suivant la règle du “livre social” et en sachant l’appliquer correctement ? Pour le comprendre, nous devons d’abord élucider ce qu’est un “jeu de langage”. Nous l’avons vu : une flèche ne signifie rien en elle-même. Nous avons appris à suivre la règle énoncée par la flèche. Mais cette règle s’inscrit elle-même dans un “jeu de langage”. Chez Wittgenstein, un “jeu de langage” (1954) désigne l’insertion du langage dans les activités qui permettent à la fois d’en éclairer la teneur et de le doter d’une signification naturalisée. Le mot “schtroumpf” est un bon exemple : pour le lecteur, il ne devient progressivement compréhensible qu’en expérimentant et recoupant ses multiples occurrences (“schtroumpf” dans telle situation, “schtroumpf” dans telle autre) qui permettent d’identifier des interactions mais également des normes, des valeurs, des fonctions, des usages. Ainsi, la signification d’un mot est le carrefour de ses occurrences situées. Pour autant, les “jeux de langage” ne sont pas sans règles : ils sont corrélés à une grammaire qui en explicite les conditions d’application et de compréhension, compte tenu de la “forme de vie” dans laquelle s’insèrent ces mêmes “jeux de langage” et ces mêmes “règles d’usage” (Ambroise et Laugier, 2011, p. 17). Ainsi, nous ne pouvons comprendre le mot “schtroumpf” qu’en saisissant les règles régissant son utilisation (dans telle situation, à tel moment) et le cadre social, cognitif, voire biologique de ses usagers (les schtroumpfs).

Dans le cadre de l’atelier cité (“Designing And Creating A Social Book App Using Open-source Technologies”), que signifie donc “livre social” ? Autrement dit : dans quelles activités est prise cette expression ? La page de présentation et le PDF offrent respectivement quelques éléments de compréhension : le “livre social” (“social book”) est présenté comme la possibilité donnée aux lecteurs de participer à la reconstruction dynamique d’un objet appelé “livre”, conçu grâce à des technologies adéquates. Le “livre social” nécessite également de créer des signes “affordants”, qui fassent sens pour des personnes n’ayant pas nécessairement connaissance de ce type d’objet : ils doivent rentrer dans leur projet (lire) alors que leur système de pertinence (normes, habitudes, valeurs), pour citer le phénoménologue Schütz, est différent. Ainsi, le “livre social” doit intégrer d’anciennes configurations qui permettent à un lecteur d’en reconnaître l’utilisabilité.

Résumons en reprenant les notions de règle, d’apprentissage et de jeux de langage : en suivant cet atelier, c’est-à-dire la règle d’O’Reilly (penser tout objet informatique comme un service communautaire et participatif), les personnes apprenaient à matérialiser convenablement ce qui est appelé “livre social”. En effet, toute règle implique un apprentissage convenable : nous nous voyons gratifier ou sanctionner en fonction de notre comportement dans notre tentative pour appliquer une règle. Ici, l’auteur de l’atelier apprend littéralement aux personnes à adapter l’objet nouveau qu’ils fabriquent (“livre social”) à des habitudes anciennes par le truchement des “affordances”. Ainsi, l’objet sera jugé convenable s’il satisfait le système de pertinence des lecteurs et s’il est intégré à une nouvelle matérialité (le livre numérique). Enonçons-le clairement : les affordances servent un objectif politique qui consiste à doter les apprenants de vérité* de moyens pour “dresser” à leur tour les personnes utilisant leur futur dispositif. Non seulement les programmes de vérité créent des jeux de langage et des règles d’usage mais, bien plus, ils contribuent à réaffirmer ou à réifier les “formes de vie” des personnes y recourant. Par conséquent, en appliquant la règle d’O’Reilly, nous sommes censés faire la démonstration que nous savons adapter son programme, décliné ici pour le monde de l’édition, à des situations sociales et des systèmes de pertinence résistants (il reste bien évidemment à le vérifier pour les autres ateliers).

Le rôle des cadres d’écriture

Si le programme des Tools of Change est si respectueux du programme initial d’O’Reilly c’est parce qu’il a fait l’objet de cadrages. En effet, la première version de la page d’accueil de l’édition 2007 de Tools of Change comportait un appel à participation dont les exigences étaient très claires. Les propositions devaient porter sur les nouveaux modèles économiques, marketing, entrepreneuriaux, techniques, juridiques dans l’édition numérique. Un formulaire suivait ce premier cadrage : il demandait aux futurs conférenciers de renseigner un certain nombre de champs (type d’intervention, résumé, etc.).

C’est manifestement un “cadre d’écriture” (Béguin-Verbrugge, 2006) qui contraint les énonciateurs à produire un énoncé en conformité avec la communauté de discours à qui il est adressé. Cet outil transforme donc les paroles en langue : il institutionnalise des actes individuels en les conformant aux matières textuelles de cette communauté par le truchement d’un dispositif technique qui définit implicitement des règles d’appartenance. Sans grande surprise, les conférences proposées répondent au programme de Tim O’Reilly de 2007 à 2013 : le programme renvoie aux conférences parce que les conférences renvoient au programme. C’est bien de cette circularité tautologique que le programme tire sa vérité.

Les relayeurs de vérité

Il bénéficie également d’effets d’autorité et de visibilité : la structuration du site Internet est presque restée inchangée d’un point de vue technique, verbal et iconique. Or, elle donne une place centrale à ce programme, aux conférenciers et aux sponsors. Le menu, par exemple, comporte un onglet “programme” (“program”) à partir duquel le lecteur peut accéder à la liste des conférences, à la biographie des conférenciers et à leur présentation. La communauté choisit ainsi d’incarner le programme d’O’Reilly en donnant corps aux relayeurs de vérité* :

Toutes les biographies présentes sur l’ensemble des éditions ont à peu près la même forme : elles sont écrites à la troisième personne, comme si l’énonciateur avait cherché à effacer les marques de subjectivité pour objectiver l’énoncé. Il comporte essentiellement des indications sur l’apparence (Goffman, 1973), c’est-à-dire le statut social du conférencier (“Founder”, “CEO”). Le passage d’un poste à l’autre, toujours précisé, a une fonction de légitimation : tel conférencier a le droit de parler parce qu’il a démontré qu’il était capable de s’adapter aux transformations du monde, comme l’incarne le programme d’O’Reilly. Les votes du public (quatre étoiles sur 5 pour la conférence citée ci-dessus) viennent ratifier la participation de la conférencière, c’est-à-dire son degré de conformité avec le programme fixé par O’Reilly. Encore une fois, la boucle est bouclée : la conférence répond au programme parce que le programme a imposé un format à la conférence qui elle-même est validée par une instance textuelle du public…

Maîtres archaïques, passeurs et généalogistes de vérité

Enfin, ce programme porte la marque de plusieurs Maîtres de Vérité, dont certains ont même été oubliés. D’autres Maîtres sont représentés mais absents : c’est par exemple le cas de Bob Stein, directeur de l’Institut pour le Futur du Livre, qui a développé avec une équipe la notion de “networked book”, à partir de la théorie hypertextuelle de Ted Nelson, et un logiciel d’annotation des textes, CommentPress. Pour l’édition 2008, l’un de ses collaborateurs (Ben Vershbow) était chargé de relayer son programme dans les Tools of Change (“Books as conversation”). Dans sa perspective, les marges sont comparées à des espaces publics dans lesquels les lecteurs entretiennent un dialogue. Si ce programme a pu investir un lieu tel que Tools of Change, c’est parce qu’il est compatible avec celui d’O’Reilly (qui se réfère en permanence à l’“intelligence collective”) : on parlera à leur sujet de programmes de vérité compatibles* à partir desquels sont articulées de nouvelles communautés de discours.

Kevin Kelly et Henry Jenkins sont des Maîtres occasionnels* : ils apparaissent respectivement dans l’édition 2011 et 2013 des Tools of Change. Ils ont aidé à structurer les industries du web : fondateur de Wired, le premier est connu pour avoir largement contribué à la diffusion en entreprise des thèses de la contre-culture américaine (Turner, 2012) favorable à un renversement sociétal reposant sur l’informatique. Dans sa conférence datée du 16 février 2011, Kelly fait des livres “2.0” des “conversations” : ils seraient en adéquation avec la structure même du web, constitué de liens reliés entre eux.

Henry Jenkins est un universitaire américain : professeur au MIT, il a contribué à la légitimation de la formule “2.0” et a offert un programme durable aux industries du web à travers la notion d’“emporwerment” (Bouquillion et Matthews, 2010). Dans un entretien daté du 13 février 2014, Jenkins défend ses thèses sur le “transmedia” assimilé à une “conversation” (sic) entre supports médiatiques. La culture imprimée est également associée à un modèle vertical, par opposition à la culture horizontale du web collaboratif. C’est précisément le programme d’O’Reilly et notamment des Tools of Change : la page et le support imprimé sont des figures métonymiques d’un ancien monde. On perçoit un axe programmatique de vérité* qui finit par s’organiser autour de cet artefact.

Comment expliquer une telle convergence ? Tous se réfèrent à la “conversation” ou au “dialogue”. Le texte de Tim O’Reilly (“What is Web 2.0”) contient lui-même des références à ces notions résumées dans une métaphore : le “cerveau global” (“global brain”). Dans sa perspective, le web est un “dialogue mental” (“mental chatter”) et une “voix intérieure”. Ces thèses sont d’inspiration cybernétique et cognitiviste : elles doivent à plusieurs Maîtres de vérité archaïques* dont certains se sont suffisamment lus pour construire des axes programmatiques*. À partir de la cybernétique de Wiener et des travaux de Bateson sur la conscience, McLuhan a par exemple construit sa théorie communicationnelle du support : il considérait ainsi que les hommes étaient reliés par un même système nerveux grâce aux télévisions, aux transistors et aux machines informatiques. Or, cette théorie est au cœur du programme de vérité de Bob Stein, l’un des Maîtres absents de Tools of Change, qui s’est souvent référé à McLuhan pour fabriquer ses artefacts. On le trouve également chez O’Reilly.

Des passeurs de vérité* ont travaillé à l’articulation de ces programmes de vérité ; Steward Brand est l’un d’eux. Méconnu, il aurait pourtant eu un rôle fondamental dans le croisement de la contre-culture américaine, de la cybernétique et de l’informatique (Turner, 2012). Liberté d’entreprendre, renversement des pouvoirs et convergence médiatique : le programme d’O’Reilly est une actualisation de cette synthèse qu’on trouve défendue dès les années 90 dans Wired, fondé par un intime de Steward Brand, Kevin Kelly, qui intervint également aux Tools of Change.

Mais Tim O’Reilly a des liens beaucoup plus explicites avec Steward Brand. Le 5 septembre 2012, il participa ainsi à un séminaire organisé par ce dernier, qui se chargea de résumer son intervention (“Birth of the Global Mind”). Steward Brand fait mine de résumer telle quelle la pensée d’O’Reilly, en multipliant les marqueurs du discours rapporté (“he says”, citations), mais il ne choisit que quelques éléments d’une intervention d’une heure et trente minutes : ceux qui lui permettent de créer une filiation naturelle entre la contre-culture américaine et le Web 2.0. Plus qu’un passeur de vérité, Brand est un généalogiste de vérité*, comme en témoigne l’évocation d’une lecture antique d’O’Reilly sur la Grèce du IVème siècle av. J.-C qui aurait influencé sa conception du “cerveau global”.

Bilan partiel : “faire, c’est refaire”

Au terme de ce parcours, on voit combien le programme de vérité de Tim O’Reilly s’appuie sur des programmes antérieurs qui, eux-mêmes, portent la trace de programmes archaïques* ; nous pourrions sans douter remonter ainsi jusqu’à l’antiquité. Ce n’est évidemment ni mon propos ni mon objectif : à la suite de Castoriadis et Ricoeur (2015) ou du philosophe analytique Nelson Goodman (1992[1978), je souhaitais seulement montrer que nous ne faisons que produire des “synthèses nouvelles” : le rassemblement hétéroclite et cohérent d’éléments passés est la condition même de la nouveauté. Ainsi :

Faire, c’est faire. (Goodman)

Pour autant, cette synthèse ne s’appuie pas sur des éléments qu’il suffirait de combiner ou d’associer, comme dans une recette de cuisine, pour en concevoir une nouvelle. Les éléments combinés sont en fait dynamiques : ils font l’objet d’une analyse, d’un diagnostic, qui modifient leur signification, avant d’être associés à d’autres éléments, eux-mêmes soumis à examen et en mouvement.

Ainsi, en construisant son programme, O’Reilly choisit un type d’éléments comme déterminants et en minimise d’autres ; il produit une définition, s’interroge, bénéficie de l’apport de sa communauté de discours : bref, des éléments plus ou moins stabilisés (l’idée du “cerveau global”, par exemple) subissent un processus de transformations continues.

Par conséquent, “nous ne pouvons penser la notion d’interruption que sur le fond de l’idée de continuation” (Ricoeur, 2015, p. 49 ; je souligne) : nous ne pouvons penser le “Web 2.0” que dans la dynamique des éléments mouvants qui en composent le programme. C’est précisément ce mouvement qui est la condition de la durabilité de certains phénomènes sociaux ; ils suivent, pour reprendre la sociologie d’Andrew Abbott, un “processus graduel de métamorphose” (Demazière et Jouvenet, 2016, p. 18).

“Candide 2.0” : la circulation d’un programme

Introduction

Comment cette configuration nouvelle s’est-elle matériellement incarnée dans des artefacts techniques ? Candide 2.0 hérite en partie des programmes institués par Tools of Change. En effet, l’un de ses maîtres d’œuvre est Ben Vershbow, conférencier à Tools of Change, pour qui les livres sont des “conversations”, comme le pensaient déjà O’Reilly et d’autres Maîtres de vérité. Or, Ben Vershbow est le directeur du NYPL Labs, le laboratoire d’expérimentations de la New York Public Library, qui lança en 2010 un nouveau projet éditorial : Candide 2.0.

Candide 2.0 se présente comme un dispositif d’annotation de texte, qui repose techniquement sur l’architecture de Digress.it, un plugin pour WordPress présenté comme une déclinaison de CommentPress, le logiciel développé par l’équipe de Bob Stein (identifié comme un Maître occasionnel* pour qui les livres sont des “conversations”, rappelons-le). Il permet de découper le texte de Voltaire en chapitre que les lecteurs sont appelés à commenter dans les marges. Avant d’analyser le dispositif, je m’attarderai sur le texte de présentation du projet (voir Figure ci-dessous), pour savoir si nous avons affaire à une autre communauté de discours.

Une altération du programme de Tim O’Reilly (1)

Ce petit texte témoigne d’une altération (Jeanneret, 2014) du programme de vérité d’O’Reilly : il ne s’agit en effet plus d’ouvrir le texte au tout venant mais d’en préparer la circulation sociale (“preparing the ground for a fertile public conversation”), en s’appuyant sur un fonctionnement vertical, contraire à l’horizontalité du “Web 2.0”. Ainsi, différents professionnels (universitaires, traducteurs, entre autres) ont été réquisitionnés pour faire ce travail préparatoire.

L’énonciateur fait appel à une métaphore, classique dans l’histoire de la lecture et des textes religieux, pour qualifier cette entreprise (voir Figure ci-dessous) : les lecteurs sont comparés à des jardiniers (“gardeners”) qui cultivent la terre du livre en plantant des graines (“seeds”). L’annotation remplit ici une fonction d’encadrement de l’interprétation : la lecture ne peut s’épanouir que dans la médiation. Nous sommes ici loin de la transparence promise par le “Web 2.0” et bien en présence d’une nouvelle communauté de discours qui définit d’autres normes et règles. Pour autant, le programme d’O’Reilly et des autres Maîtres est bien présent : ainsi dans l’à propos du site on retrouve bien l’idée que les marges sont des espaces publics qui favorisent la communication (“margins themselves as a way to communicate with other readers in this public forum.”). Indice d’un passage d’un programme dans un nouvel espace discursif.

Le programme de vérité de cette communauté s’appuie sur trois éléments (Jeanneret, 2014) pour asseoir son autorité :

- le piège, d’abord, qui consiste à capter la mémoire des formes pour s’approprier les valeurs attachées aux propriétés nobles du support matériel, comme cette illustration de Candide de 1922 (voir Figure ci-dessus).

- Déplacée de son contexte énonciatif initial, cette illustration devient un nouveau signe : c’est un avatar qui ne sert plus seulement à illustrer une sentence de Voltaire (“Lets us cultivate our garden”) mais à inscrire le projet dans une continuité herméneutique.

- De ces transformations naît enfin une chimère, un assemblage de signes ou, dans notre cas, un assemblage contradictoire de plusieurs programmes de vérité, soit une ligne programmatique divergente* qui se distingue de l’axe programmatique* (convergence consensuelle). La ligne programmatique divergente du projet est la suivante : marges comme conversations [Tools of Change]/encadrées par des autorités [Candide 2.0].

Une altération du programme de Tim O’Reilly (2)

Comment ces différents programmes s’articulent-ils dans le dispositif ? Comment est mise en signe la confiance ? Quelles compétences sont valorisées ? Pour répondre à ces questions, je propose de mener maintenant une analyse dite “sémiotechnique” du logiciel d’annotation :

Le premier chapitre de Voltaire est découpé en paragraphes qui forment chacun une unité à commenter dans un “cadre-document” (Souchier, 1999) au centre. À côté de chacun d’eux, un signe (phylactère) indique le nombre de commentaires produits par les personnes. Il sémiotise l’ambition dialogique du dispositif, typique du “web 2.0”. Le cadre-document à droite permet d’accéder aux commentaires, répartis par paragraphe. Il est continuellement présent à l’écran, malgré la longueur du texte. Ainsi, ce dernier ne peut pas être lu sans que le lecteur ne soit incité à activer les commentaires : ils forment une unité visuelle et technique indissociable. L’activation du signe “+” déplie l’ensemble des commentaires de chaque paragraphe (il est également possible de commenter le chapitre sans cibler un paragraphe en particulier) :

Chaque annotateur est identifié par un nom (l’anonymat est possible) et peut préciser sa fonction. Dans ce cas, le directeur de la Fondation Voltaire a par exemple écrit un commentaire sur le premier chapitre. Le logiciel met en forme son énoncé, d’un point de vue graphique et énonciatif : il ajoute en effet automatiquement le verbe “says” dans une stratégie de délégation énonciative. Chaque annotation s’inscrit une nouvelle fois dans un régime dialogique. En activant le lien, j’accède à l’ensemble des commentaires et des commentateurs du texte, à une liste de “jardiniers”, dont certains sont présentés sur une page à part. Décorrélés du texte, les commentaires peuvent être retrouvés en contexte en cliquant sur “go to thread” (en bas) :

Ces allers-retours permanents ne sont pas anodins : ils créent du sens (c’est pourquoi on préfèrera l’appellation “signe passeur” à “lien hypertexte”). C’est comme si l’entièreté du texte était contenu dans une seule annotation, dans la mesure où elle renvoie techniquement à lui et qu’elle donne accès à l’ensemble des commentaires.

Ce dispositif répond au programme énoncé en introduction : pour reprendre la métaphore végétale, l’annotation contient en germe le dispositif entier. Les technologies de navigation le confirment. Chaque fois qu’un commentaire était produit dans un chapitre, l’état chromatique de ce dernier se modifiait :

Les annotateurs avaient donc une fonction directe sur le dispositif. À partir de leurs “actèmes” (Bouchardon, 2011), soit le résultat d’un geste avec une interface, ils en modifiaient l’apparence. Gestuellement et énonciativement, ils ratifiaient le programme de vérité de Candide 2.0. Certes, on trouve bien des traces programmatiques* de Tools of Change, comme des marques énonciatives (“says”) et des simulacres de conversation (phylactère). Mais ce programme a été négocié pour satisfaire les exigences d’une nouvelle communauté de discours, plus universitaire, dont les critères de légitimation passent par une validation entre pairs. Pour le dire autrement : le programme initial d’O’Reilly été ajusté-corrigé*.

Bilan partiel : un “outil de vérité”

Candide 2.0 s’appuie ainsi sur des technologies dites “2.0” mais les articule à des attentes de verticalité : si le dispositif finit par s’ouvrir à un plus large public, c’est après avoir été investi par des professionnels du savoir, parmi lesquels des membres de la Fondation Voltaire. Ces gardiens de vérité* des communautés de discours contrôlent l’interprétation des matières textuelles. Cela dit, ils sont en prise avec un logiciel qui a sa propre logique et qui structure en partie leur programme et leur vérité. La phrase de Voltaire (“Il faut cultiver notre jardin”) se trouve ainsi écartelée entre plusieurs programmes de vérité, dont on peut entendre les bruissements au sein des artefacts techniques.

Bien évidemment, le dispositif ne porte aucune trace explicite de ces débats : il se présente dans l’évidence d’un “outil de vérité” (Robert, 2010), alors que nous avons bien vu qu’il configurait techniquement le statut des personnes, leurs gestes et leur parole. Cette évidence produit un curieux effet. En effet, Voltaire nous invite à nous tourner vers le quotidien, en nous défaisant des spéculations métaphysiques pour trouver la vérité en nous. Or, le dispositif renoue paradoxalement avec cette activité spéculative en encadrant toute prise de parole qui ne viendrait pas d’un gardien de vérité (un universitaire, un traducteur).

Conclusion partielle : l’art rigoureux de faire des mondes

L’entreprise de Tim O’Reilly et, plus globlement, de sa communauté de discours s’apparente à un monde fabriqué, dans le sens donné par le philosophe Nelson Goodman à ce terme (1992 [1978]). Un monde fabriqué est un ensemble de signes, de normes, de valeurs, de personnes, de catégories articulé de manière pertinente et correcte*.

Nous avons en effet bien vu que le Maître et sa communauté s’ajustaient en permanence : ils émergent d’un processus de co-constitution, qui s’appuie sur des configurations antérieures réactualisées. Ainsi, la fabrication n’a absolument rien de péjoratif : elle indique simplement la dimension processuelle de l’émergence des mondes. La pertinence et la correction* d’un monde fabriqué se juge à partir de critères endogènes : nous ne pouvons pas l’évaluer au moyen d’une théorie cohérentiste, pour laquelle une vérité existerait indépendamment des critères dont nous nous doterions pour l’appréhender. Les mondes se jugent à partir des mondes.

Qu’on veuille bien accepter d’innombrables versions concurrentes du monde, vraies ou correctes, ne veut pas dire que tout va bien, que les longs récits valent mieux que les courts, qu’on ne distingue plus les vérités des faussetés, mais seulement que la vérité doit être concçue autrement que comme correspondance avec un monde déjà fait.” (Goodman, 1992[1978], p. 135)

Est-ce dire, pour autant, que n’importe qui peut créer un monde et faire valoir sa vérité ? Tout se vaut-il ? La théorie de Goodman est-elle relativiste, post-moderne et déconstructiviste, comme le prétendent certaines lectures polémiques9C’est d’autant plus étonnant de la part de Jacques Bouveresse, qui est l’un de nos philosophes contemporains les plus intéressants. Dans un livre d’entretiens parus en 1998 (Bouveresse, 1998, p. 46), il reconnaît à la fois son admiration pour Goodman et déclare son hostilité pour sa notion de “monde”, dont il semble faire un parangon des théories phénoménologiques et relativistes. ? Certainement pas : comme nous l’avons déjà vu, les mondes sont auto-contraints et ajustés. Leurs créateurs cherchent à maximiser leur convenabilité et leur correction* en s’appuyant sur des programmes passés et en cherchant à se faire socialement, institutionnellement et ontologiquement admettre. Bref, tout le monde ne peut pas faire de mondes : ils exigent une grande rigueur d’exécution.

Plus précisément, Goodman identifie au moins cinq procédés nécessaires à la fabrication d’un monde :

- Composition et décomposition : les faiseurs de monde recourent à des catégories, des étiquettes, des parties et des sous-classes pour rassembler ou dissocier des entités, de manière à en faire des ensembles plus vastes, grâce à un travail de distinctions, de définitions, de connexions. Ainsi, écrit Goodman, “des événements temporellement distincts peuvent être réunis par un seul nom propre ou identifiés comme constituant un “objet” ou “une personne”” (p. 24).

- Pondération : la singularité ou l’originalité d’un monde tient moins à la présence de certaines entités (par exemple, deux syllabes similaires dans deux langues différentes) qu’à l’intensité qui leur est donnée (la manière d’accentuer chacune de ces syllabes). Au sein d’un monde, des hiérarchies sont organisées pour donner une place à certains éléments et pour en minimiser d’autres.

- Agencement : pour comprendre ce qu’est l’agencement, il suffit de mettre les épisodes d’une série dans le désordre (l’exemple n’est pas de Goodman) ou de changer la place d’un épisode au sein d’une saison. Le mode d’articulation d’une entité donnée (un épisode ici) à d’autres entités (d’autres épisodes) est déterminant dans son appréhension : nous ne prêtons pas les mêmes significations aux entités en fonction de leur agencement.

- Suppression et supplémentation : un monde ne naît jamais ex nihilo. Il est toujours articulé à d’autres mondes ou à d’anciennes configurations de monde. Goodman distingue deux opérations de correction : la suppression (coupe d’un autre monde ou d’une ancienne configuration) et la supplémentation (comblement d’un trou).

- Déformation : les faiseurs de monde se livrent à des déformations qui “peuvent être considérées soit comme des corrections, soit comme des distorsions”. Le premier cas relève de la suppression et de la supplémentation. Le second consiste à déformer une entité (une image, par exemple) pour lui faire prendre de nouvelles formes, comme dans le morphing.

Tim O’Reilly et sa communauté de discours ne procèdent pas autrement : en choisissant le terme “Web 2.0”, il a rassemblé, de son propre aveu, des réalités différentes sous une même classe. Il s’est ensuite livré à un travail de pondération en établissant des hiérarchies entre les entités de sa recomposition : ainsi, l’intelligence collective, les technologies (XML, AJAX) et le marketing y tiennent une place fondamentale. On les retrouve dans d’autres programmes (celui de Caterina Fake, par exemple, la fondatrice de Flickr) mais dans des proportions moindres. O’Reilly s’est également appuyé sur d’anciennes configurations et d’anciens mondes pour bâtir son programme, en mettant de côté tout ce qui aurait pu empêcher son implantation : certes, la contre-culture américaine a sans doute influencé l’élaboration de son monde mais la plupart des thèses de cette dernière serait inapplicable telle quelle. C’est pourquoi son programme se livre à des déformations, comme sait parfaitement le faire le capitalisme du web contemporain (Bouquillion et Matthews, 2010) : dans sa perspective, l’intelligence collective sert avant tout des objectifs marchands.

Encore, une fois, rien ne permet de conclure à des stratégies de falsification ou à une “idéologie” : nous avons affaire à une déformation d’un programme de vérité antérieur, qui peut être nourri par des ambitions sincères, même si elles sont parfaitement contestables. Nous-mêmes pouvons y adhérer un moment (pour poser une question sur Facebook) et être contestataires à un autre (dans un cours, dans une conférence). L’efficacité des programmes de vérité tient précisément à leur capacité à susciter la mauvaise foi.

Conclusion : des communautés de vérité

Au terme de ce (long, trop long) parcours, je ne peux pas encore tout à fait conclure : il nous reste à affronter des questions difficiles, avant de rassembler la matière théorique et empirique dans une proposition ou un concept à mettre au travail (les “communautés de vérité”), afin d’en éprouver l’efficacité sur d’autres corpus ou “terrain”.

Cinq problèmes avant de conclure

Réalistes et nominalistes : l’éternel débat…

Le premier problème, impossible à traiter exhaustivement ici, est celui de la vérité et de ses conditions d’exercice (voir Brague et al., 2004) : plus de 2000 ans de littérature opposent ici les “réalistes” (Benoist, 2017) et les “nominalistes” (Panaccio, 2012) avec des querelles importantes et passionnantes entre scolastiques médiévaux (Libera, 2014) ou contemporains (Armstrong, 2010) autour des “universaux”.

Pour le dire très grossièrement et schématiquement, les premiers estiment que le monde existe indépendamment de notre perception, de nos valeurs, de nos usages ou de nos catégories, tandis que les seconds pensent qu’il n’y a pas de monde en dehors de ces perceptions, de ces valeurs, de ces catégories et de ces usages ; ils n’ont aucune existence transcendante10Pour être plus précis, “les [nominalistes] n’acceptent dans le monde extérieur que des entités singulières, — cet homme, ce cheval, cette plage de rouge — et veulent expliquer par le fonctionnement du langage ou celui de l’esprit les phénomènes de catégorisation, d’abstraction ou de conceptualisation générale ; [les réalistes], au contraire, pensent qu’il y a dans la réalité, indépendamment de nous, des unités autres qu’individuelles, des genres et des espèces par exemple, des propriétés générales ou ds entités abstraites comme des nombres, des ensembles, des natures communes ou des valeurs.” (Panaccio, 2012, p. 10–11.. Le post-modernisme, la déconstruction et les thèses relativistes, dans leurs versions caricaturales ou caricaturées, sont des illustrations célèbres du “nominalisme”. Jacques Bouveresse (1998) résume très bien la première position :

Comme beaucoup de réalistes, j’ai tendance à penser que la réalité, la réalité physique en tout cas ne nous a pas attendus pour exister et que, même si nous n’existions pas, elle aurait encore exactement les propriétés qu’elle a. Je crois aussi que ce sont bien ces propriétés que la science réussit, au moins jusqu’à un certain point, à connaître.

Ces débats, très techniques, sont éminemment politiques : ainsi les journalistes rappellent souvent que les “faits sont têtus” à un personnel politique enclin à parler de “point de vue” ou de “manipulation” ; en dépit des interprétations, il existerait donc un monde stable qu’il suffirait d’interroger pour connaître la vérité (Les Décodeurs du Monde reposent sur cet impensé épistémologique). Le réalisme est nécessaire dans un monde soumis à l’instabilité. C’est pourquoi il est aujourd’hui retravaillé (Benoist, 2017) à tel point que certains parlent d’un “nouveau réalisme” (Ferraris, 2014).

…des gammes intermédiaires

Cette distinction, apparamment rigide, reconnaît cependant des gammes intermédiaires. Ainsi, le “réalisme” n’est pas un ensemble de thèses consensuelles, loin de là : non seulement il est critiqué depuis l’Antiquité mais il admet lui-même des postures nuancées, sinon contradictoires. En 1978, le philosophe analytique Putnam a imaginé une expérience de pensée (“le cerveau dans une cuve”), reprise dans les films eXistenZ ou Matrix, pour illustrer et finalement mettre à mal la version la plus radicale du “réalisme” métaphysique et transcendant, après y avoir pourtant souscrit. En adhérant finalement à un “réalisme interne” puis pragmatiste (Tiercelin, 2013), Putnam illustre merveilleusement le caractère circonstancié de ses positions, qui fluctuent temporellement et sans doute en fonction d’événements personnels et politiques.

De la même manière, Nelson Goodman, auquel j’ai eu recours tout au long de ce billet, n’est pas un affreux relativiste, comme ses caricatures le suggèrent parfois : c’est un “nominaliste” rigoureux, qui n’admet la “construction” ou la “fabrique” des mondes qu’au prix de critères redoutables (composition, pondération, etc.). Ainsi, tout le monde ne peut pas fabriquer “son” monde ou “sa” vérité (essayez, vous y renoncerez rapidement : dire n’importe quoi ne s’improvise pas). Elle nécessite tout un processus complexe d’ajustement et de correction* au cours duquel se co-constituent, dans ma perspective, les Maîtres de vérité, les programmes de vérité et les communautés de discours à partir d’anciens mondes, d’anciennes configurations, ou d’anciens programmes. On est loin d’une fabrique ex nihilo par l’esprit !

…des conceptions différentes de la vérité

Toutes ces positions relèvent grosso modo de trois conceptions classiques de la vérité (Pouivet, 2008) :

- la théorie de la vérité correspondance : une proposition est vraie si elle correspond aux faits, c’est-à-dire aux propriétés du monde (exemple typique : Les Décodeurs du Monde ou l’exemple canonique de la philosophie logique de Tarski : ““La neige est blanche” si et seulement si la neige est blanche”) ;

- la théorie de la vérité cohérence : une proposition est vraie si elle appartient à un système de croyances reliées de manière cohérente les unes aux autres composant une “structure néotique” (par exemple, “Google Analytics” n’est pas vrai en soi : les chiffres et les audiences mesurées ne sont vrais que dans le système — médiatique, journalistique, universitaire, etc. — qui les reconnaît comme tels) ;

- la théorie pragmatiste de la vérité : une proposition est vraie si elle permet à une personne de s’orienter utilement dans le monde, en dépit de sa cohérence ou de sa correspondance (ce n’est qu’en partie le cas des programmes de vérité).

On pourrait sans doute rajouter une quatrième position à partir du livre de Benoist (2017), de thèses bien connues de Wittgenstein (tantôt brandi par les réalistes, tantôt par les nominalistes), des sociologues de l’action dite “située” (Formel et Quéré, 1999) ou l’anthropologie interprétative (Geertz, 2012) :

- la théorie contextuelle ou située de la vérité : la vérité dépend du contexte dans lequel nous sommes insérés et à partir duquel nous pouvons alors statuer. Ainsi, l’énoncé célèbre ““la neige est blanche”” si et seulement si la neige est blanche” ne peut être pensé que de manière contextuelle ; sa blancheur n’a pas d’existence absolue, en dehors des conditions dans lesquelles nous pouvons la constater et de la personne qui fait le constat (le scientifique ne regarde pas la neige de la même manière que le promeneur). Pour autant, cette théorie ne sombre pas dans un relativisme radical des “points de vue” : au sein de chaque classe de points de vue existent des critères et des cadres relativement stables qui permettent de statuer sur un phénomène donné malgré son caractère situé et de limiter “la multiplication des descriptions” (Ogien et Quéré, 2005b)

De l’ensemble de ces distinctions, distinctions et oppositions je retiendrai plusieurs leçons : d’abord, la vérité est liée à un discours, qu’il soit porté sur un état du monde, sur un réseau interne de croyances ou sur les intérêts propres d’un individu. Elle implique toujours une énonciation et un positionnement : dire quelque chose qui coïncide avec les faits (première définition), ne pas se contredire (deuxième définition), être sincère (troisième définition), reconnaître potentiellement la validité d’un point de vue (quatrième définition). Pour autant, cette énonciation est contrainte : elle doit chaque fois satisfaire des critères auquel un individu doit se soumettre, quelle que soit sa conception de la vérité, pour voir son discours légitimé. Autrement dit : la vérité implique des procédures, qui peuvent être endogènes ou exogènes. Ces critères sont ceux dont se dotent une communauté à un moment donné, qu’elle pense être les meilleurs, pour statuer sur un ensemble de phénomènes.

Pourquoi tient-on à la vérité ? Parce qu’on tient à la justice. (…) Pour qu’il y ait un monde humain il faut qu’il y ait une confiance dans les faits, dans les procédures d’établissement mais surtout dans les hommes. (…) Si vous ne comptez que sur l’aspect du réel, comme le font aujourd’hui certains réalistes (…) ça ne suffira pas (…) entre les deux, il y a le discours humain et la confiance (…) (Worms, 2018)

La deuxième leçon à tirer — sans doute la plus importante — est la suivante : le réel, même souverain, ne suffit pas. Certes, il résiste (“les faits sont têtus” disent les journalistes) et malgré des tentatives pour le déformer, pour le conformer à un programme donné, il continue de se présenter dans sa vérité. Alors pourquoi des personnes le suivent, en dépit de sa non conformité aux propriétés du monde ? Parce que tout programme implique la confiance et la légitimité que nous avons en un Maître qui le porte (un individu, une institution, etc.). Autrement dit : nous devons d’abord garantir un certain type de relations entre les hommes avant de prétendre pouvoir fonder un discours sur la vérité. La confiance, la sincérité et la légitimité sont au coeur des programmes de vérité.

…des programmes de vérité

C’est pourquoi l’adhésion en un programme est si fluctuante : comme les philosophes, nous changeons de régime de vérité selon les moments, les lieux, les occasions en fonction du degré de confiance, de sincérité et de légitimité que nous attribuons aux autres et que nous avons envers nous-mêmes. Nous ne devons pas conclure, sur cette base, que tout se vaudrait et que la vérité serait hors de notre portée : ces allers-retours sont l’indice d’une recherche pour établir les critères de sa validité.

Mais pourquoi devrait-on garder la tête sur les épaules ? Pourquoi traîner ce cadavre qu’est votre mémoire, de crainte de contredire ce que vous avez affirmé publiquement en telle ou telle occasion ? Supposez que vous deviez vous contredire ; et alors ? (Emerson, Compter sur soi, Allia, 2018[1847], p. 23)